18.09.2025

Deepfake’i: Rodzaje, Zagrożenia i Sposoby Wykrywania

Jeszcze kilka lat temu większość ludzi nie słyszała o pojęciu deepfake. Dziś trudno ich uniknąć. Od viralowych filmów po internetowe oszustwa – deepfakes coraz mocniej kształtują to, jak konsumujemy i postrzegamy treści cyfrowe.

Jeszcze kilka lat temu większość ludzi nie słyszała o pojęciu deepfake. Dziś trudno ich uniknąć. Od viralowych filmów po internetowe oszustwa – deepfake’i coraz mocniej kształtują to, jak konsumujemy i postrzegamy treści cyfrowe.

Technologia, która za nimi stoi, jest jednocześnie fascynująca i niepokojąca. Z jednej strony pokazuje niezwykłe możliwości współczesnej sztucznej inteligencji. Z drugiej – tworzy nowe zagrożenia związane z oszustwami, dezinformacją i kradzieżą tożsamości, które muszą być pilnie adresowane przez firmy, rządy i użytkowników indywidualnych.

Zrozumienie, jak działają deepfake’i, jakie mogą mieć pozytywne zastosowania i jak je wykrywać, jest kluczowe dla każdego, kto porusza się we współczesnym świecie cyfrowym.

W tym artykule przyjrzymy się bliżej czym są deepfake’i, jak powstają, jakie istnieją ich rodzaje, jakie mają pozytywne i negatywne zastosowania, jak można je wykrywać oraz co mówi o nich prawo.

Czym są deepfake’i?

Termin deepfake pochodzi od słów „deep learning” (rodzaj modelu AI) i „fake” (fałszywy). Odnosi się do mediów syntetycznych – obrazów, nagrań audio lub wideo – które zostały zmanipulowane lub w pełni wygenerowane przez sztuczną inteligencję, aby wyglądały i brzmiały jak prawdziwe.

Deepfake’i wykorzystują zaawansowane sieci neuronowe do podmiany, modyfikacji lub generowania twarzy, głosów czy całych scen. W przeciwieństwie do Photoshopa czy aplikacji do wymiany twarzy, które wymagają ręcznej edycji, deepfake’i są tworzone przez algorytmy trenowane na ogromnych zbiorach danych. Dzięki temu potrafią odtwarzać mimikę, wzorce mowy i zachowania z zadziwiającą dokładnością. Deepfake’i są dynamiczne i bardzo realistyczne, co sprawia, że trudno je wykryć gołym okiem. Z czasem uczą się i poprawiają, stając się coraz trudniejsze do odróżnienia od prawdziwych treści.

Kiedy pojawiły się deepfake’i? Krótka historia

Pomysł wykorzystania komputerów do generowania mediów syntetycznych nie jest nowy, ale deepfake’i w obecnym rozumieniu zaczęły powstawać dopiero na początku lat 2010, kiedy przełomy w deep learning uczyniły tę technologię realną. W latach 2017–2018 deepfake’i trafiły do mainstreamu, gdy w sieci zaczęły krążyć filmy z celebrytami wygenerowane przez AI. Często były one tworzone w sposób nieetyczny i bez zgody osób przedstawianych, co wywołało burzliwą debatę o etycznych skutkach tej technologii.

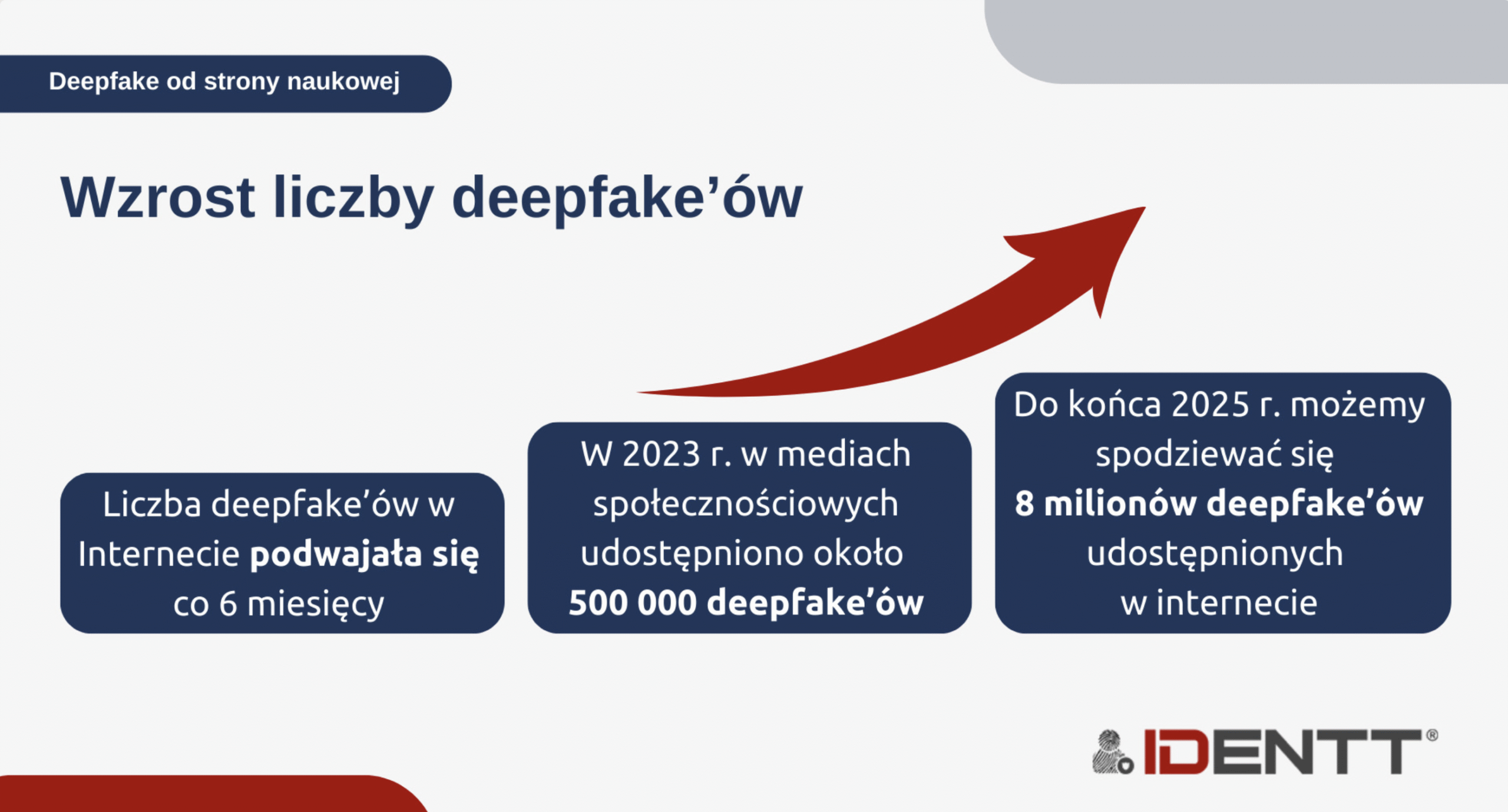

Od tego czasu deepfake’i stały się bardziej dostępne i powszechne. Narzędzia i aplikacje, które kiedyś wymagały specjalistycznej wiedzy, są dziś dostępne dla każdego przy minimalnych umiejętnościach technicznych. W efekcie technologia wyszła poza rozrywkę i ciekawostki, wchodząc w dużo poważniejsze obszary. Dziś deepfake’i wykorzystywane są w kampaniach dezinformacyjnych, ingerencji w wybory, oszustwach korporacyjnych i ukierunkowanych cyberatakach. Ich rosnąca zaawansowana natura sprawiła, że stały się centralnym problemem dla specjalistów ds. cyberbezpieczeństwa, rządów i zwykłych użytkowników.

Jak powstają deepfake’i?

Deepfake’i są najczęściej tworzone przy użyciu Generative Adversarial Networks (GANs). GAN składa się z dwóch sieci neuronowych, które działają przeciwko sobie, aby ulepszać rezultaty. Pierwsza, zwana generatorem, tworzy fałszywe media – obraz, nagranie głosu czy wideo. Druga, zwana dyskryminatorem, ocenia, czy treść wygląda autentycznie. Z czasem generator uczy się na swoich błędach, aż do momentu, gdy nawet dyskryminator nie potrafi odróżnić treści od prawdziwych.

Proces trenowania wymaga ogromnych zbiorów rzeczywistych danych. Aby stworzyć przekonujący wideo deepfake danej osoby, AI potrzebuje godzin materiału pokazującego ją podczas mówienia, poruszania się i wyrażania emocji. W przypadku audio deepfake’ów system musi być trenowany na nagraniach głosu w różnych tonach i kontekstach. Im większy i bardziej zróżnicowany zbiór danych, tym bardziej realistyczny efekt końcowy.

Po wytrenowaniu system może generować treści tak realistyczne, że potrafią one oszukać nie tylko zwykłych widzów, ale też zaawansowane systemy biometryczne. Dlatego deepfake’i są coraz częściej wykorzystywane w oszustwach, phishingu i kradzieży tożsamości.

Jaki jest proces tworzenia deepfake’ów?

Tworzenie deepfake zazwyczaj przebiega w kilku etapach, łącząc zaawansowane techniki z łatwo dostępnymi narzędziami.

- Zbieranie danych: Zdobywanie zdjęć, filmów i nagrań audio osoby będącej celem – często z mediów społecznościowych, wywiadów czy wystąpień publicznych.

- Wstępne przetwarzanie danych: Czyszczenie i porządkowanie materiału; wyodrębnianie twarzy z kadrów wideo, izolowanie próbek głosu, normalizacja formatów i przygotowanie zbiorów do trenowania.

- Trenowanie modelu: Uczenie sieci neuronowych – zwykle przy użyciu GAN lub podobnych technik – na przygotowanych danych, aby model nauczył się cech twarzy, mimiki i wzorców głosu danej osoby.

- Generowanie: Uruchamianie wytrenowanego modelu w celu produkcji syntetycznych obrazów, audio lub wideo, przy jednoczesnym dostrajaniu parametrów dla poprawy realizmu i redukcji błędów.

- Postprodukcja: Udoskonalanie efektu końcowego za pomocą narzędzi edycyjnych, usuwanie błędów, korekta oświetlenia czy kolorów i zwiększenie ogólnej jakości.

- Czas i zasoby: Czas tworzenia różni się znacząco – proste, niskiej jakości deepfakes można wygenerować w kilka sekund za pomocą gotowych narzędzi, podczas gdy wysokiej jakości treści wymagają dni lub tygodni trenowania i mocnego sprzętu.

Jakie są rodzaje deepfake’ów?

Deepfakes mogą przyjmować różne formy. Do najczęstszych należą:

- Wideo deepfake’i – filmy generowane przez AI z podmienionymi twarzami, zmienioną mową lub fałszywymi scenariuszami.

- Audio deepfake’i – syntetyczne głosy naśladujące prawdziwe osoby. (Zobacz nasz osobny artykuł o audio deepfakes).

- Obrazy deepfake’i – zdjęcia stworzone lub zmodyfikowane przez AI, używane zarówno w sztuce, jak i w dezinformacji.

- Tekstowe deepfake’i – artykuły, posty czy wiadomości generowane przez AI w celu wprowadzania w błąd lub szerzenia propagandy.

- Manipulacja 3D i całym ciałem – zmiana nie tylko twarzy, ale i całych sylwetek w wideo lub środowiskach 3D.

- Deepfakes w czasie rzeczywistym – podmiana twarzy i głosu na żywo podczas transmisji czy rozmów wideo.

- Media syntetyczne i awatary AI – całkowicie wygenerowane przez AI postacie lub awatary używane w grach, marketingu czy interakcjach społecznych.

Czy deepfake’i mogą być użyteczne?

Pomimo swojej złej reputacji, nie wszystkie deepfake’i są szkodliwe. Technologia ta ma wiele potencjalnych korzyści, jeśli jest używana etycznie. W branży rozrywkowej deepfakes wykorzystuje się do tworzenia realistycznych efektów specjalnych, odmładzania aktorów czy nawet przywracania zmarłych artystów na ekran. Obniża to koszty produkcji i otwiera nowe możliwości dla twórców filmowych.

W edukacji deepfake’i mogą ożywiać historię, odtwarzając postacie czy wydarzenia w angażujący sposób. Mogą także służyć do tworzenia realistycznych symulacji szkoleniowych dla lekarzy, pilotów czy żołnierzy, zapewniając immersyjne i skuteczne doświadczenia edukacyjne.

Dostępność to kolejny obszar, w którym deepfake’i mogą odegrać pozytywną rolę. Awatary AI mogą zapewniać tłumaczenia na język migowy, przekładać treści mówione na różne języki czy tworzyć spersonalizowaną komunikację dla osób z niepełnosprawnościami.

Nawet w marketingu deepfake’i umożliwiają tworzenie spersonalizowanych kampanii, w których treści są dostosowane do poszczególnych odbiorców, czyniąc komunikację bardziej angażującą i zapadającą w pamięć. Mogą też pomóc zachować dziedzictwo, cyfrowo odtwarzając znane postacie i przekazując ich przesłanie przyszłym pokoleniom.

Jakie zagrożenia niosą deepfake’i?

Ciemna strona deepfake’ów tkwi w ich nadużyciach. Jednym z najpoważniejszych zagrożeń jest dezinformacja. Deepfake’i mogą być wykorzystywane do tworzenia fałszywych przemówień, zmanipulowanych nagrań informacyjnych czy politycznych, które mogą wpływać na opinię publiczną i podważać zaufanie do instytucji.

Innym poważnym ryzykiem są oszustwa. Przestępcy coraz częściej używają deepfake’ów audio i wideo, aby podszywać się pod zaufane osoby, w celu autoryzacji fałszywych płatności lub zdobycia poufnych informacji. Stanowi to ogromne zagrożenie zarówno dla firm, jak i osób prywatnych.

Na przykład w 2024 roku firma z Singapuru padła ofiarą deepfake podszywającego się pod jej CEO – pracownik przelał 25 mln USD, wierząc, że polecenie było prawdziwe, a dopiero później odkryto, że nagranie było syntetyczne. Pokazuje to, jak deepfake’i mogą omijać tradycyjne mechanizmy weryfikacji i prowadzić do ogromnych strat finansowych. Podobnie raport Veriff z 2025 roku wykazał, że obecnie 1 na 20 nieudanych procesów weryfikacji tożsamości wynika z manipulacji deepfake, co dowodzi, że zjawisko to stało się problemem powszechnym.

Kolejnym zagrożeniem są naruszenia prywatności. Wiele deepfake’ów tworzonych jest bez zgody przedstawianych osób – często w celu nękania, zniesławienia czy publikowania niechcianych treści o charakterze intymnym. Może to mieć katastrofalne skutki dla ofiar zarówno w życiu osobistym, jak i zawodowym.

Specjaliści ds. cyberbezpieczeństwa ostrzegają również, że deepfake’i mogą służyć do obchodzenia systemów biometrycznych, takich jak rozpoznawanie twarzy, coraz częściej stosowanych w weryfikacji tożsamości i bezpieczeństwie. Wraz z rozwojem tej technologii granica między autentycznymi a fałszywymi treściami staje się coraz mniej wyraźna, co dodatkowo osłabia zaufanie do treści cyfrowych.

Jak rozpoznać deepfake?

Ręczne wykrywanie deepfake’ów staje się coraz trudniejsze, ale nadal istnieją pewne wizualne i dźwiękowe sygnały ostrzegawcze:

- Nienaturalne ruchy twarzy lub niesynchroniczne mruganie.

- Niespójności w oświetleniu (cienie, odbicia nie pasują do sceny).

- Rozmazane krawędzie lub migotanie wokół twarzy.

- Niezgodność audio-wideo (mowa nie pokrywa się z ruchem ust).

- Zniekształcenia tła lub nienaturalna „idealność” (np. zbyt gładka skóra).

Dla firm ręczne sprawdzanie to za mało. Dlatego kluczowe są rozwiązania oparte na technologii:

- Wykrywanie żywotności (potwierdzenie obecności prawdziwej osoby).

- Analiza mikroekspresji.

- Biometryczne testy oczu czy struktury twarzy.

- Narzędzia oparte na sieciach neuronowych, analizujące niewidoczne dla ludzi artefakty.

- Analiza danych multimodalnych – porównywanie obrazu, dźwięku i metadanych.

Czy deepfake’i są nielegalne?

Same deepfake’i nie są z natury nielegalne. Ich legalność zależy od tego, jak są używane. Jeśli deepfake powstaje w celach rozrywkowych, artystycznych czy edukacyjnych i za zgodą osób przedstawionych – jest zwykle zgodny z prawem. Jednak wykorzystanie deepfake’ów do oszustw, szantażu, zniesławienia czy kradzieży tożsamości jest nielegalne w większości jurysdykcji.

Sytuacja prawna nadal się rozwija – wiele rządów wprowadza lub rozważa regulacje dotyczące deepfakes. Do tego czasu zastosowanie mają istniejące przepisy dotyczące cyberprzestępczości, nękania czy własności intelektualnej.

Rządy zaczynają jednak nadrabiać zaległości. W USA ustawa Take It Down Act z 2025 roku nakłada na platformy obowiązek usuwania niechcianych intymnych treści typu deepfake. Tymczasem w Danii opracowywane są przepisy, które miałyby zakazywać udostępniania deepfake’ów lub treści generowanych przez AI bez zgody przedstawianej osoby – nawet poza przypadkami treści intymnych. Te działania pokazują rosnącą świadomość, że regulacje są konieczne, by chronić prawa jednostki i zaufanie społeczne.

Jak IDENTT chroni przed oszustwami deepfake?

W IDENTT rozumiemy rosnące zagrożenie, jakie deepfake’i stanowią dla weryfikacji tożsamości i bezpieczeństwa online. Nasze rozwiązania zostały zaprojektowane tak, aby chronić organizacje przed oszustwami, łącząc wiele warstw zabezpieczeń. Wykrywanie żywotności zapewnia obecność prawdziwej osoby w procesie weryfikacji. Analiza biometryczna porównuje cechy twarzy i tęczówki, aby potwierdzić autentyczność. Algorytmy AI do porównywania twarzy dopasowują zdjęcia z dokumentów do rzeczywistych użytkowników, a modele wykrywające na bazie sieci neuronowych oznaczają treści, które noszą ślady sztucznego generowania.

Łącząc te techniki, zapewniamy firmom silną ochronę przed oszustwami opartymi na deepfake’ach. Jest to szczególnie istotne w sektorach, gdzie weryfikacja tożsamości ma kluczowe znaczenie – takich jak bankowość, ubezpieczenia czy usługi online.

Podsumowanie: Jak poruszać się w świecie deepfake’ów

Choć deepfake’i otwierają ekscytujące możliwości w obszarach kreatywności, edukacji i dostępności, niosą też ze sobą poważne zagrożenia dla osób prywatnych, firm i całego społeczeństwa.

Najlepszym sposobem radzenia sobie w tej nowej rzeczywistości jest połączenie świadomości i technologii. Rozumiejąc, jak działają deepfake’i, znając ich potencjalne niebezpieczeństwa i korzystając z zaawansowanych narzędzi do wykrywania deepfake’ów, możemy bronić się przed manipulacją i oszustwami.

Dobrą wiadomością jest to, że technologia wykrywania rozwija się równie szybko. W IDENTT zobowiązujemy się wspierać organizacje w ochronie przed zagrożeniami związanymi z deepfake’ami, oferując narzędzia zaprojektowane tak, by zapewniały bezpieczną i wiarygodną weryfikację tożsamości. W świecie, w którym „zobaczyć” nie oznacza już „uwierzyć”, ochrona autentyczności jest ważniejsza niż kiedykolwiek.

Need a custom solution? We’re ready for it.

IDENTT specializes in crafting customized KYC solutions to perfectly match your unique requirements. Get the precise level of verification and compliance you need to enhance security and streamline your onboarding process.